L’Unesco ha pubblicato un report («Guidelines for the Use of AI Systems in Courts and Tribunals») che identifica 15 principi universali per orientare i sistemi giudiziari — nello sviluppo, acquisto e uso di sistemi di IA — in modo etico e nel pieno rispetto dei diritti umani. In particolare, il report si occupa di sicurezza delle informazioni, tracciabilità (auditability), supervisione umana e decisione umana, per promuovere un approccio consapevole da parte dei Governi e delle Amministrazioni della giustizia alle prese con l’integrazione, nell’organizzazione e nell’amministrazione della giustizia, di sistemi di IA, generativi e non.

Questi i principi:

- Protezione dei diritti umani: garantire il rispetto, la protezione e la promozione dei diritti umani e dello Stato di diritto durante l’intero ciclo di vita dei sistemi di IA.

- Proporzionalità: utilizzare sistemi di IA per raggiungere obiettivi legittimi e proporzionati nel contesto giudiziario.

- Fattibilità dei benefici: valutare i benefici potenziali dei sistemi di IA e la capacità istituzionale di realizzarli prima della loro adozione.

- Sicurezza: evitare, prevenire e mitigare danni indesiderati per le parti coinvolte, i giudici, i tribunali e il pubblico.

- Sicurezza delle informazioni: proteggere le informazioni riservate e garantire la sicurezza contro le minacce informatiche.

- Accuratezza e affidabilità: utilizzare sistemi di IA che producano informazioni pertinenti e affidabili.

- Spiegabilità: garantire che i sistemi di IA possano spiegare il razionale dietro i loro output e decisioni.

- Auditabilità: implementare misure per consentire l’audit dei sistemi di IA durante il loro utilizzo.

- Trasparenza e giustizia aperta: assicurare trasparenza riguardo allo sviluppo, al funzionamento e all’uso dei sistemi di IA.

- Consapevolezza e uso informato: comprendere le funzionalità, i limiti e i rischi dei sistemi di IA per un uso consapevole.

- Responsabilità: assumersi la responsabilità per le decisioni prese con il supporto dei sistemi di IA.

- Responsabilità e contestabilità: garantire la possibilità di contestare e verificare le decisioni supportate dai sistemi di IA.

- Supervisione e decisione umana: preservare l’intervento umano in tutti i processi decisionali supportati da sistemi di IA.

- Progettazione centrata sull’uomo e partecipativa: sviluppare sistemi di IA che rispettino la dignità e l’autonomia umana, coinvolgendo la magistratura e il pubblico nel processo di progettazione.

- Governance e collaborazione multi-stakeholder: consultare diversi stakeholder e implementare approcci partecipativi durante il ciclo di vita dei sistemi di IA.

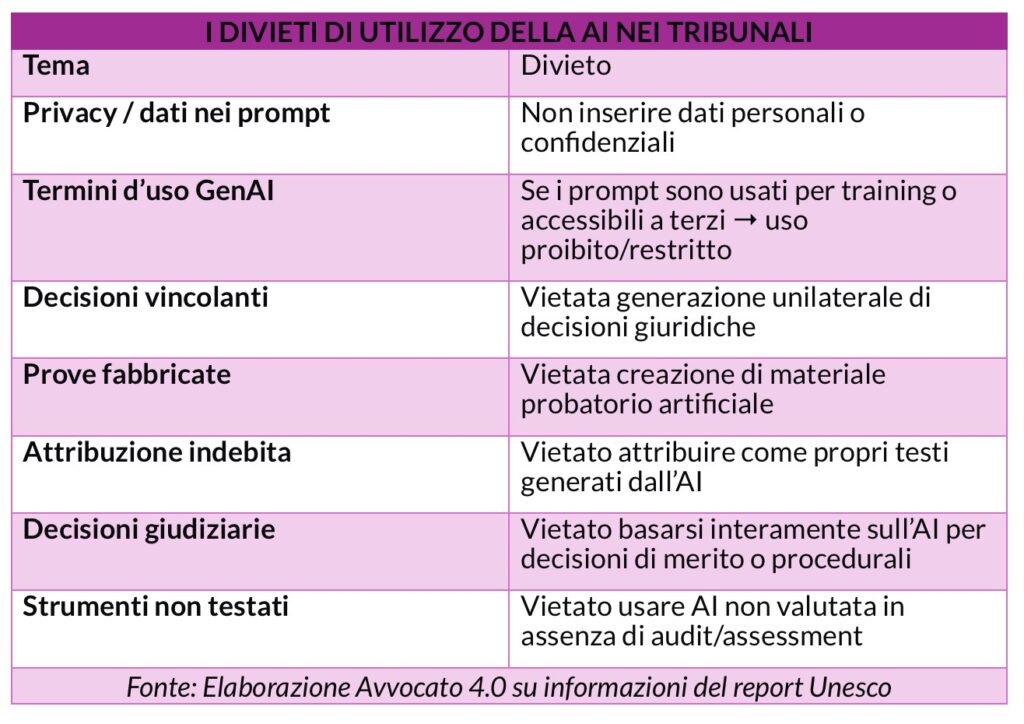

Un lungo articolo di Altalex ha commentato nel dettaglio il documento, soffermandosi sugli aspetti tecnici da non trascurare per evitare indebiti utilizzi dell’intelligenza artificiale quando viene impiegata nelle aule di un tribunale.

«Il criterio di trasparenza – sottolinea l’articolo – che colpisce di più, al momento totalmente disatteso dalle giurisdizioni italiane, riguarda la divulgazione proattiva delle informazioni chiave sui sistemi di AI utilizzati dalla magistratura. Ad esempio, le autorità giudiziarie potrebbero pubblicare un archivio online con le informazioni essenziali sui sistemi di AI adottati per amministrare la giustizia. Un archivio che includa informazioni riguardanti i dati di addestramento; il modello (ad es. variabili, pesi); se il sistema è proprietario o open source; come funzionano i sistemi di AI; chi e come li utilizza; le implicazioni per i processi decisionali giudiziari; e se le decisioni adottate con il supporto del sistema possono essere contestate».

Iscriviti alla newsletter: https://www.bebankers.it/newsletter/